ИИ-ассистент — это готовый к работе образ облачного сервера, на котором можно развернуть приватный чат-бот с искусственным интеллектом.

Решение включает два основных open-source инструмента: Ollama (платформу для управления и запуска больших языковых моделей) и Open WebUI (современный веб-интерфейс для взаимодействия с ИИ).

Ключевые преимущества решения:

полная конфиденциальность. Все данные и модели находятся на вашем сервере — это позволяет обрабатывать чувствительную информацию без передачи третьим сторонам;

предустановленные модели. Образ поставляется с набором популярных языковых моделей, готовых к работе сразу после развертывания;

простота использования. Интуитивно понятный веб-интерфейс позволяет управлять моделями, пользователями и настройками без необходимости работы с командной строкой;

гибкость. Вы можете устанавливать любые другие модели, поддерживаемые Ollama, и полноценно управлять сервером.

Образ доступен для заказа на облачных серверах и на серверах с GPU для увеличения скорости обработки запросов.

Рекомендации по конфигурациям сервера

Производительность ИИ-ассистента напрямую зависит от размера используемой языковой модели и мощности сервера. Размер модели указывается в параметрах B (например, Llama3.1:8B — 8 миллиардов параметров).

Чем больше параметров B у модели, тем выше ее качество и возможности: улучшается понимание контекста, сложные рассуждения, генерация кода и точность ответов, но одновременно возрастают требования к ресурсам сервера.

Как заказать сервер с ИИ-ассистентом

-

1

Войдите в панель управления Рег.облака.

-

2

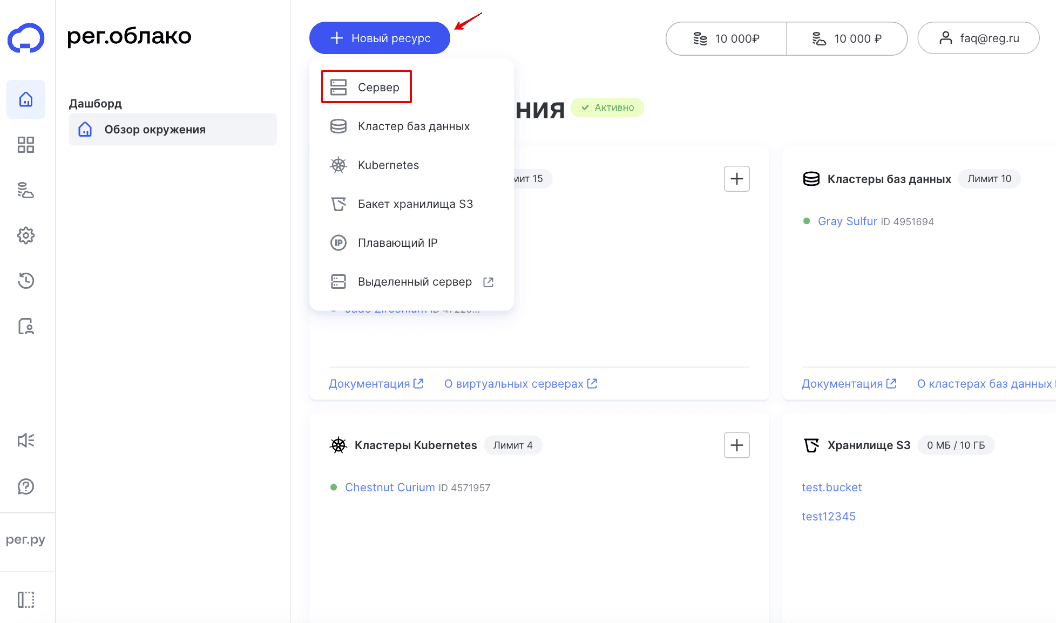

Нажмите Новый ресурс > Сервер:

-

3

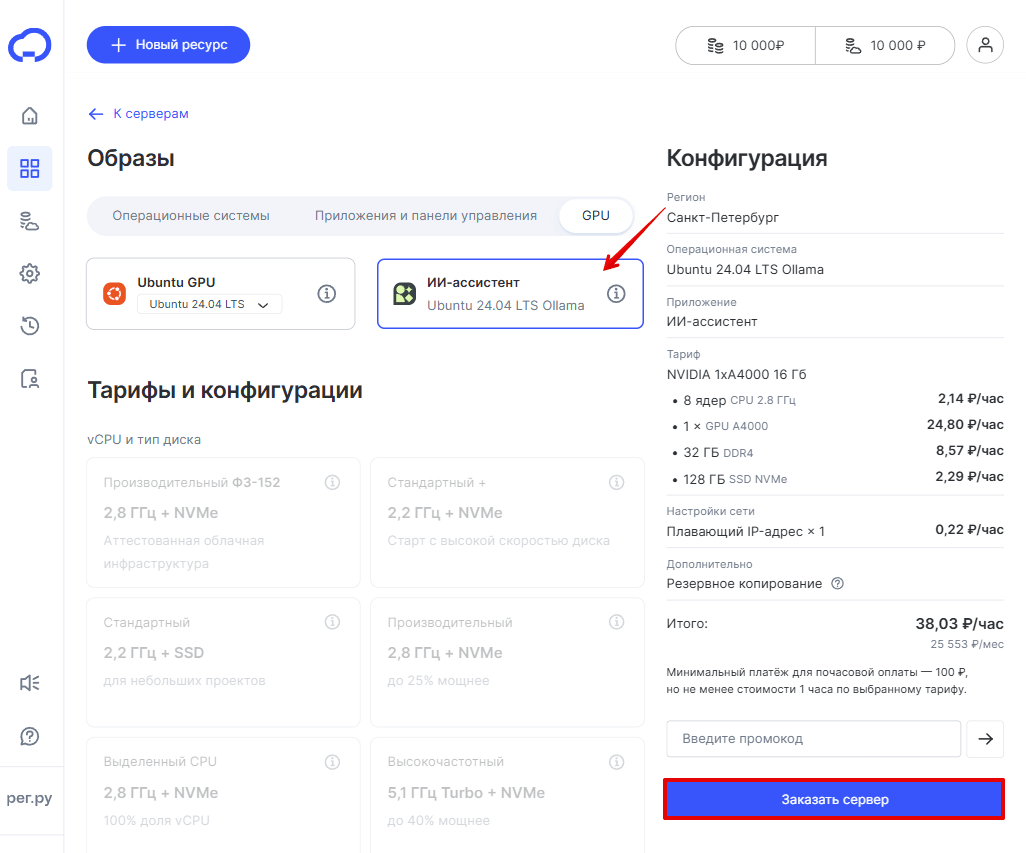

Кликните GPU и выберите ИИ-ассистент. В мастере заказа уже учтены минимальные требования для сервера. Нажмите Заказать сервер:

Как открыть приложение

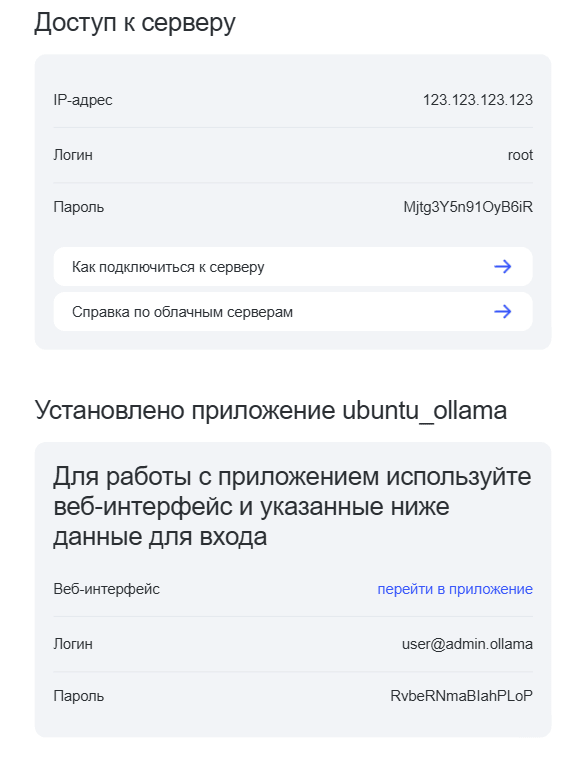

После создания сервера на ваш email придет письмо с доступами к серверу и веб-приложению Open WebUI:

Чтобы подключиться к веб-интерфейсу, кликните Перейти в приложение и введите логин и пароль из письма.

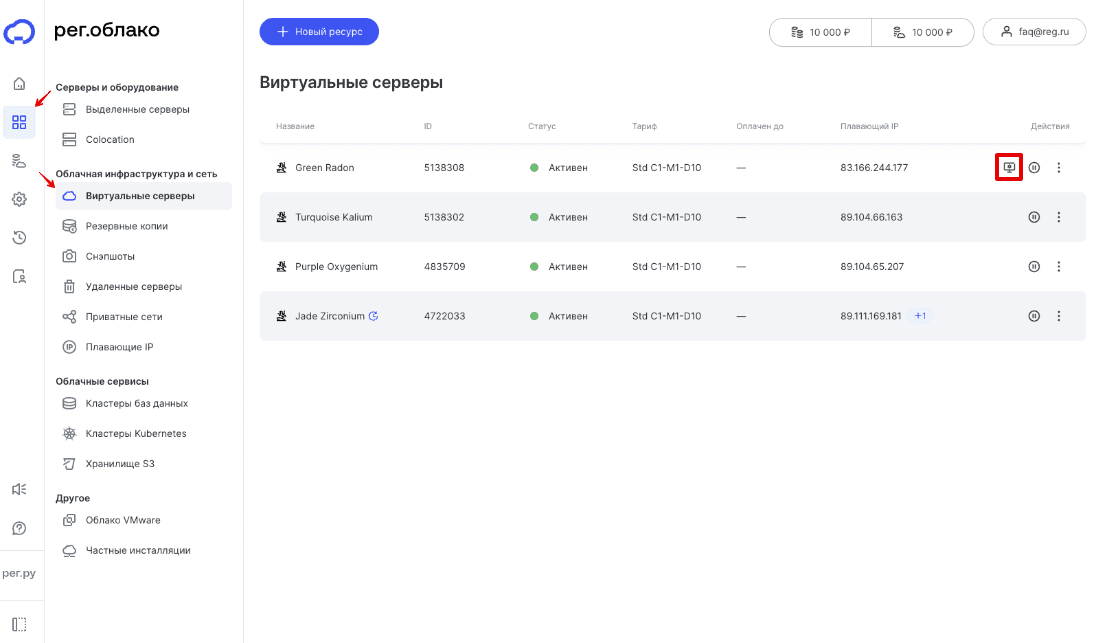

Чтобы попасть в веб-интерфейс из панели управления Рег.облака, перейдите в раздел Мои ресурсы > Виртуальные серверы и напротив нужного сервера кликните на иконку монитора с шестеренкой:

Затем введите логин и пароль из письма.

Добавление новых пользователей

Open WebUI предоставляет встроенную систему управления пользователями и группами.

-

1

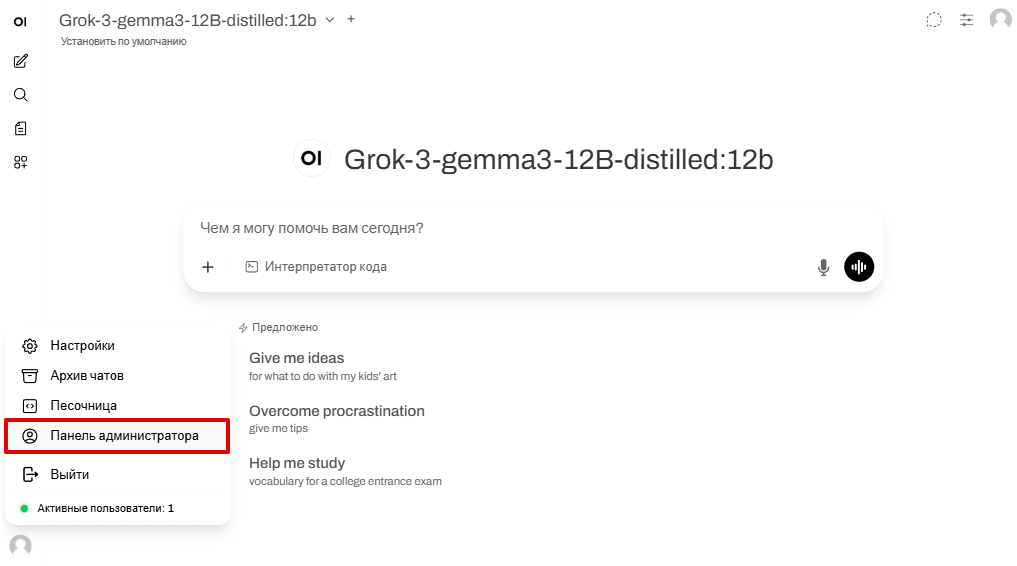

В левой боковой панели интерфейса перейдите в раздел «Панель администратора»:

-

2

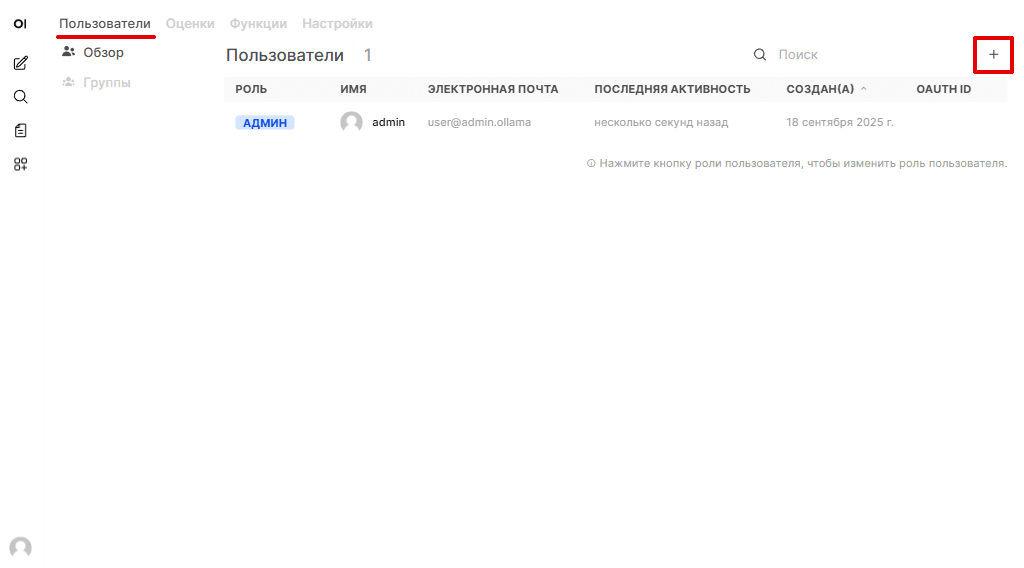

Откройте вкладку «Пользователи» и нажмите на значок +:

-

3

Заполните данные нового пользователя (имя, email, пароль) и назначьте ему роль (например, User или Admin).

Готово. Новый пользователь сможет войти в систему с собственными логином и паролем.

Управление моделями

Предустановленные модели

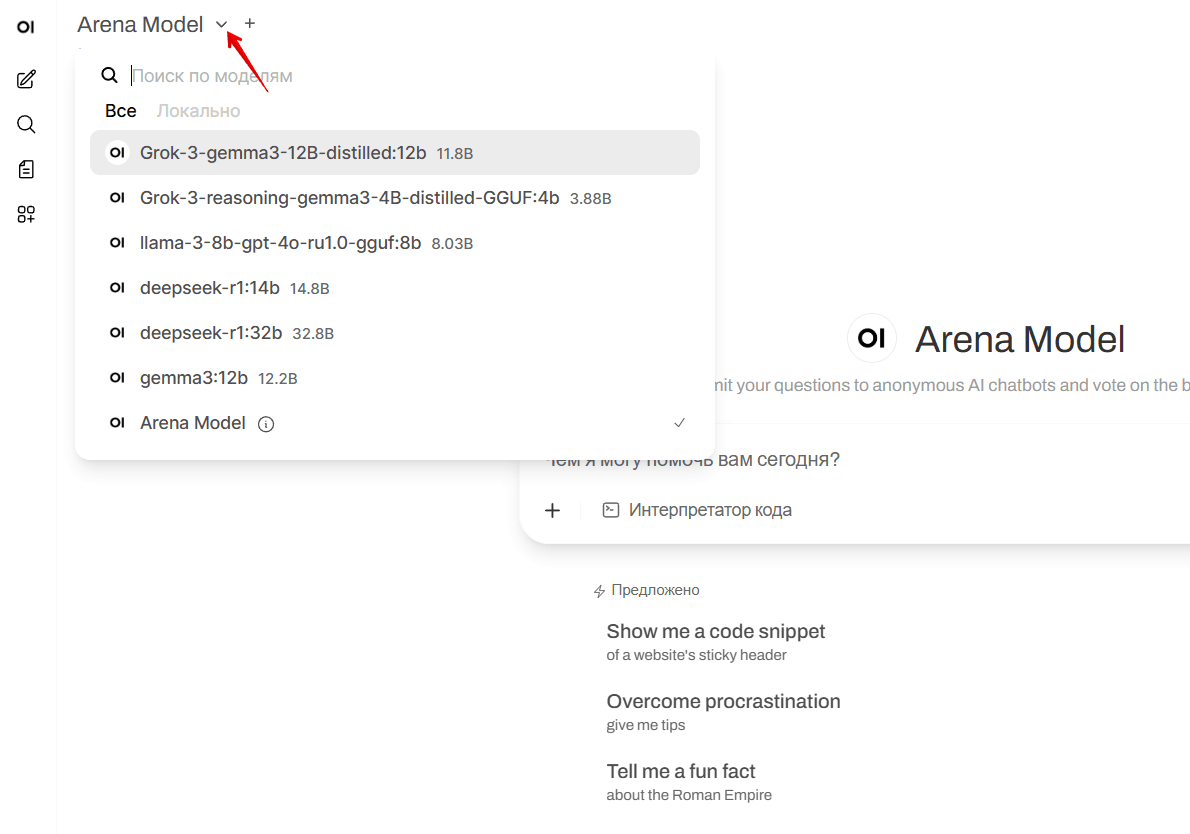

Образ поставляется с набором предустановленных моделей. Их список доступен для выбора в выпадающем меню в интерфейсе чата:

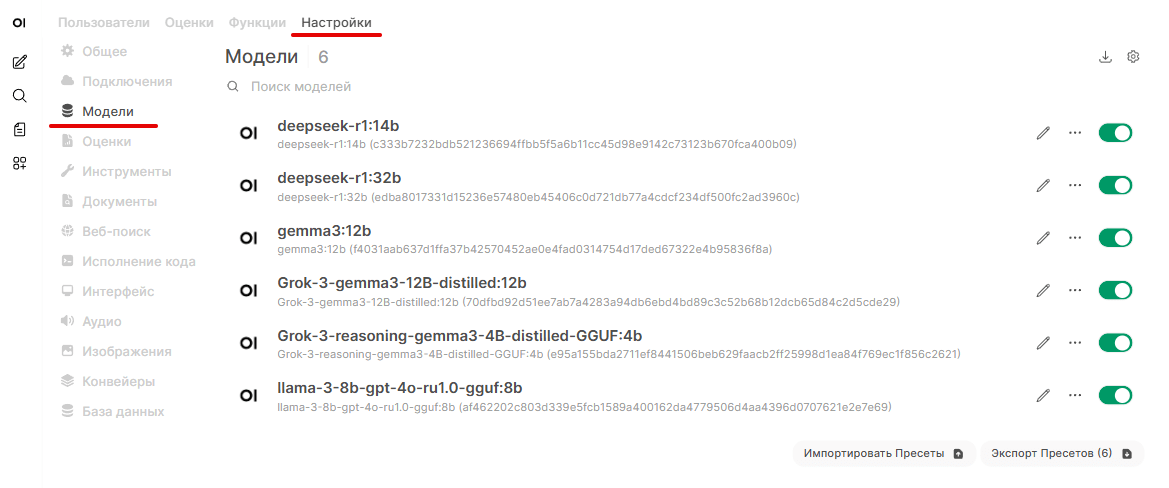

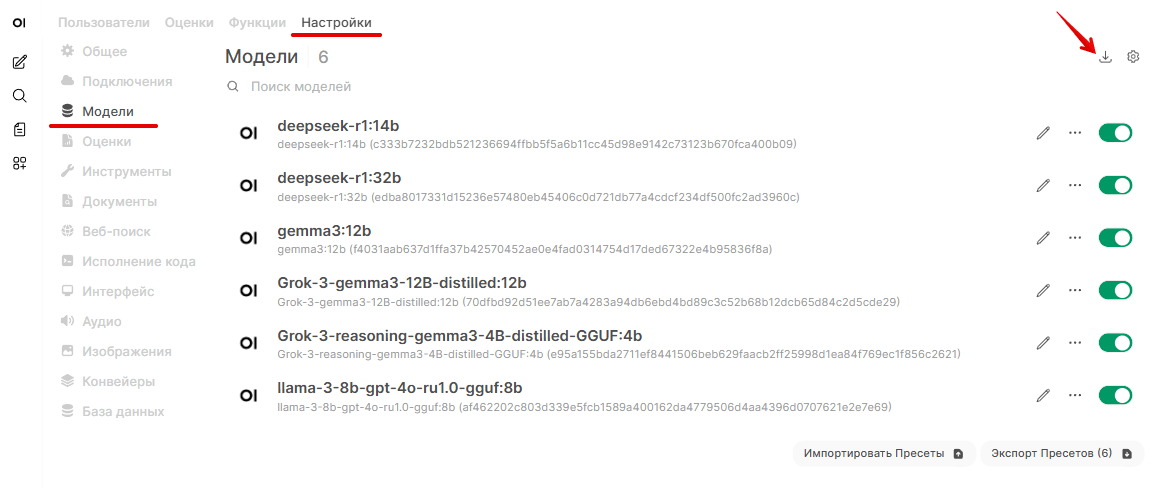

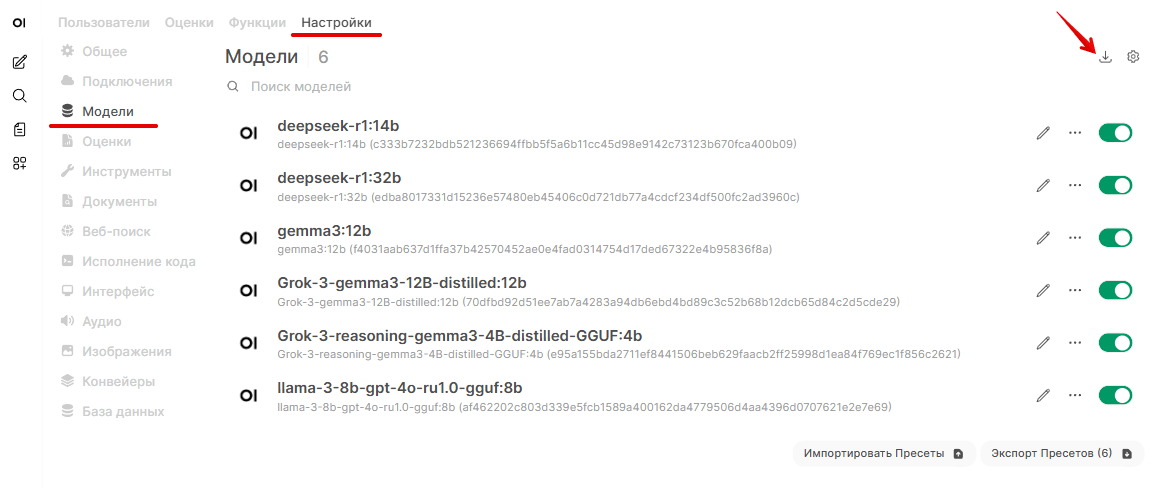

Чтобы управлять моделями в панели администратора, перейдите в Настройки > Модели:

Подробнее о всех возможностях интерфейса в официальной документации Open WebUI.

Как установить новую модель через веб-интерфейс

-

1

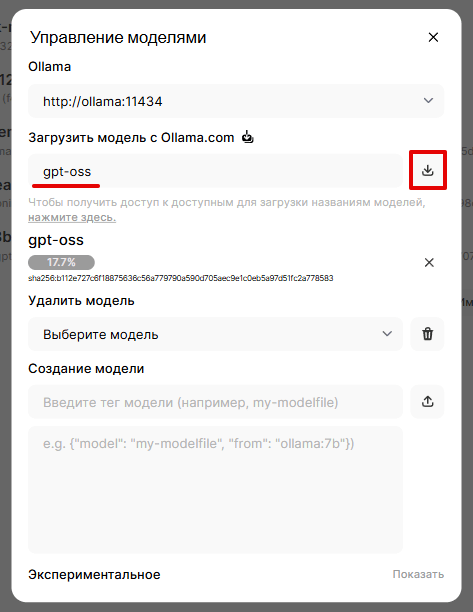

В панели администратора перейдите в Настройки > Модели и нажмите Загрузить модель:

-

2

В поле «Загрузить модель с Ollama.com» введите название модели, которую хотите скачать (например, gpt-oss), и нажмите Загрузить:

-

3

Дождитесь загрузки с официального репозитория Ollama.

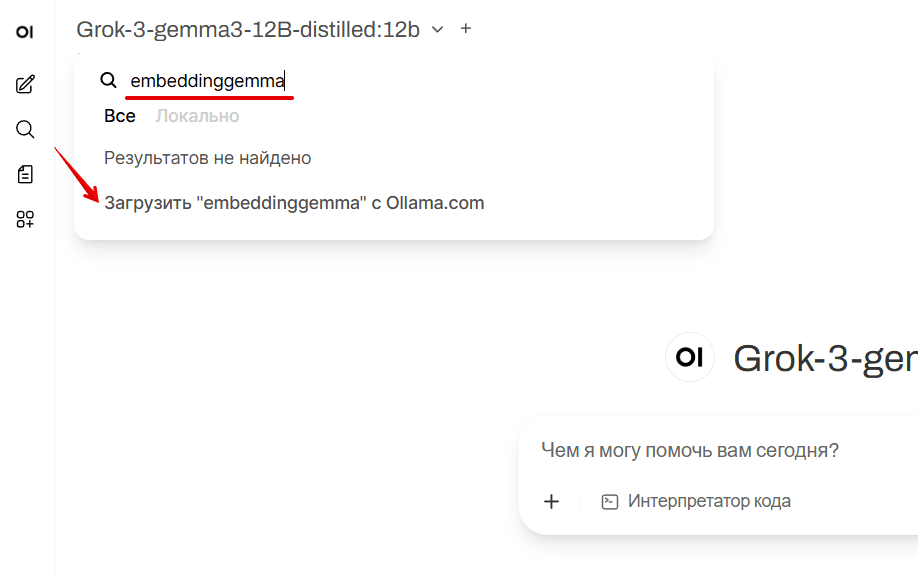

Чтобы загрузить новую модель из чата, введите название модели в поисковой строке и нажмите Загрузить с Ollama.com:

Как загрузить модель с Hugging Face

-

1

Зарегистрируйтесь или авторизуйтесь на сайте Hugging Face.

-

2

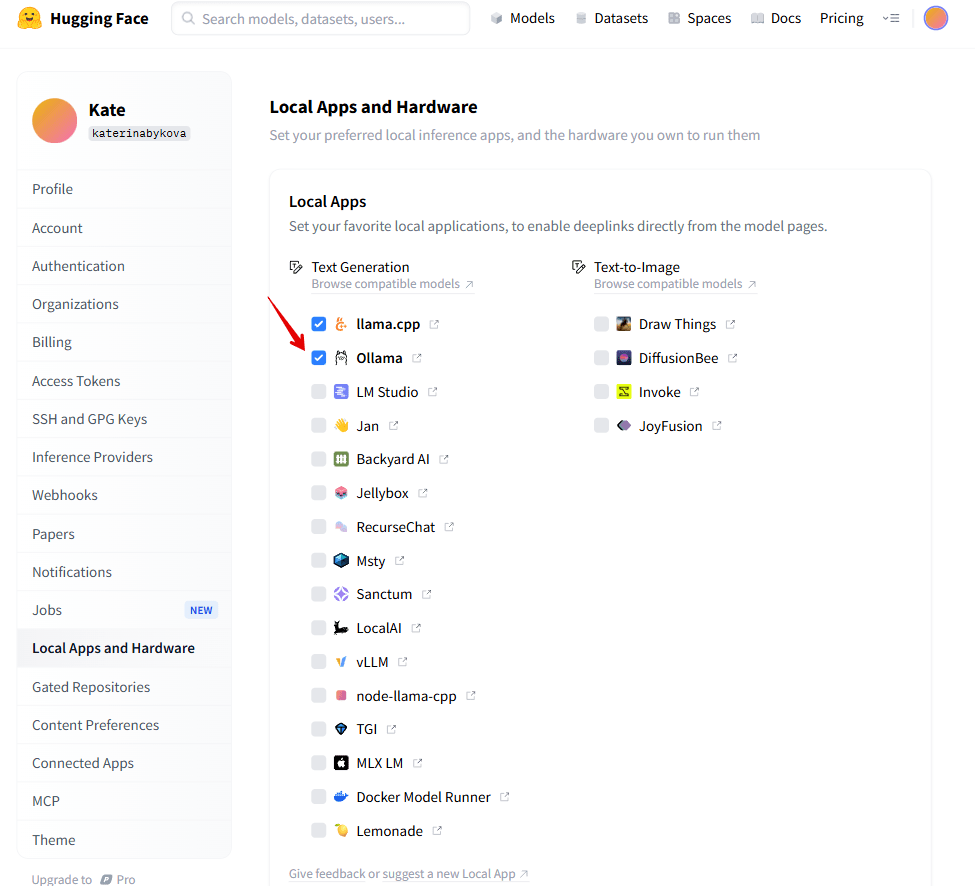

Перейдите в настройки локальных приложений.

-

3

Отметьте чекбокс с приложением Ollama:

-

4

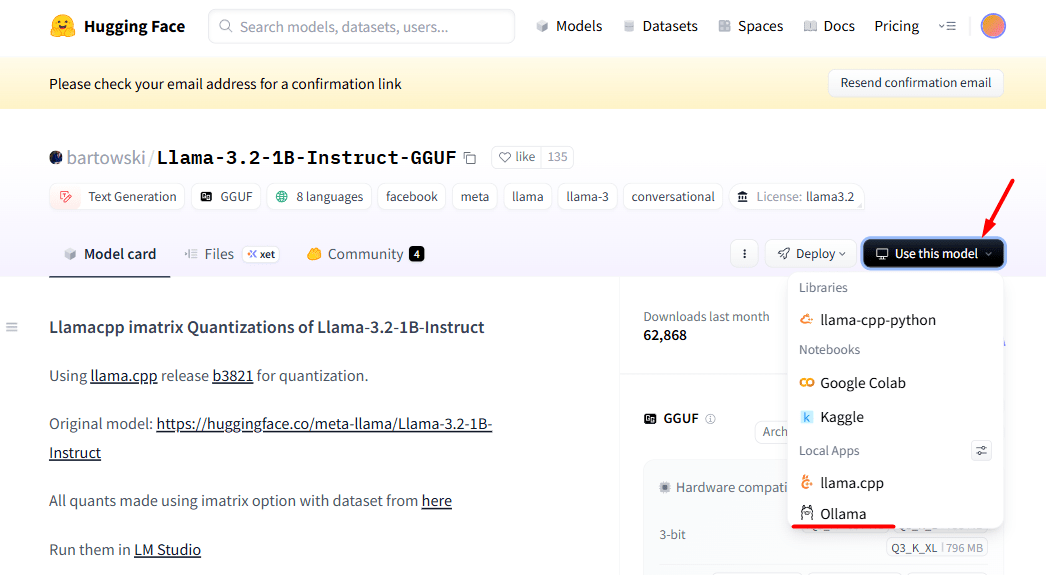

Выберите совместимую с Ollama модель, например bartowski/Llama-3.2-1B-Instruct-GGUF.

-

5

Нажмите Use this model и в выпадающем списке выберите Ollama:

-

6

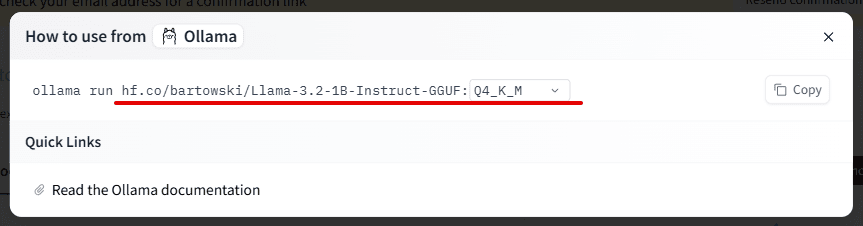

Скопируйте часть строки после «ollama run»:

-

7

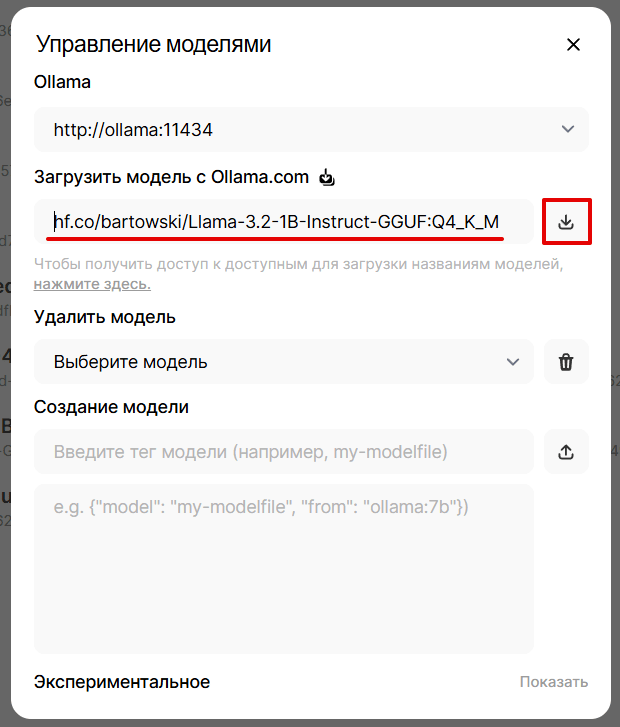

В панели администратора Open WebUI перейдите в Настройки > Модели и нажмите Загрузить модель:

-

8

В поле «Загрузить модель с Ollama.com» введите скопированную строку и нажмите Загрузить:

-

9

Дождитесь загрузки с репозитория Hugging Face.

Установка через CLI

Если вы хотите установить модель вручную через командную строку:

- 1

-

2

Загрузите модель в каталог

/opt/ollama/models:файлы модели — в папку

blobs;метаданные Ollama — в папку

manifests.